Avaliação da competição no treino de agentes autônomos com Aprendizado Profundo por Reforço em jogos de Tiro em Primeira Pessoa

Evaluating competition in training of Deep Reinforcement Learning agents in First-Person Shooter games

Paulo Bruno de Sousa Serafim

Master’s Thesis

Advisor: Joaquim Bento Cavalcante Neto

Co-advisor: Creto Augusto Vidal

Co-advisor: Yuri Lenon Barbosa Nogueira

Full text: [PDF]

Abstract (Portuguese)

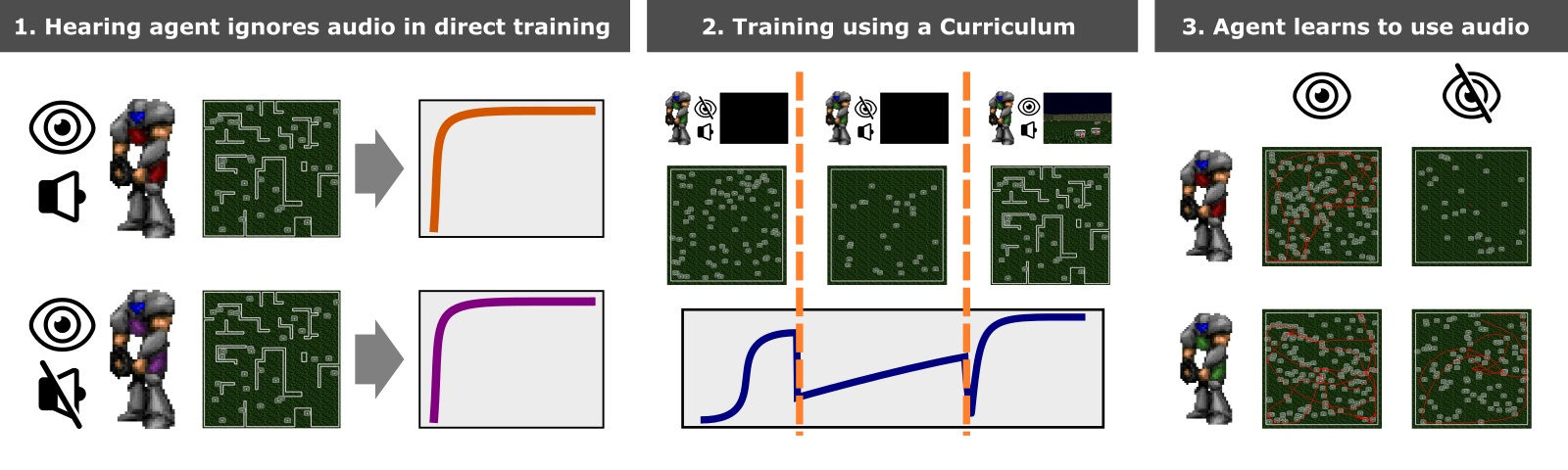

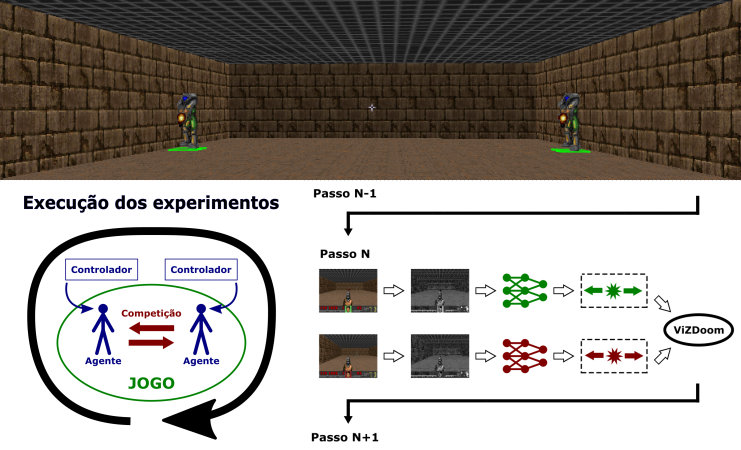

Este trabalho avalia a competição no treino de agentes autônomos imersos em jogos de Tiro em Primeira em Pessoa utilizando Aprendizado Profundo por Reforço. Os agentes são compostos por uma Deep Neural Network, treinada através da técnica Deep Q-Learning. Eles recebem como entrada somente os pixels da tela, possibilitando a criação de jogadores generalistas, capazes de jogar diversos cenários sem a necessidade de modificações adicionais. O ambiente ViZDoom, baseado no jogo Doom, foi utilizado por possuir características apropriadas como uma base de testes. Quinze agentes autônomos são divididos em três equipes, em que duas delas são treinadas através de competição entre si e a terceira treina contra inimigos que agem de maneira completamente aleatória. Os agentes desenvolvidos foram capazes de aprender comportamentos adequados para sobreviver em um cenário personalizado para partidas de um contra um. Através dos testes realizados, verificou-se que o treinamento por competição entre agentes autônomos levou a um maior número de vitórias se comparado ao treinamento contra agentes não-inteligentes.

Abstract (English)

This work evaluates competition in training of autonomous agents immersed in First-Person Shooter games using Deep Reinforcement Learning. The agents are composed of a Deep Neural Network, which is trained using Deep Q-Learning. The input of the networks is only the pixels of the screen, allowing the creation of general players, capable of handling several environments without the need for further modifications. ViZDoom, an Application Programming Interface based on the game Doom, is used as the testbed because of its appropriate features. Fifteen agents were divided into three groups, two of which were trained by competing with each other, and the third was trained by competing against opponents that act randomly. The developed agents were able to learn adequate behaviors to survive in a custom one-on-one scenario. The tests showed that the competitive training of autonomous agents leads to a greater number of wins compared to training against non-intelligent agents.

BibTeX

@mastersthesis{serafim2018avaliacao,

author = {Serafim, Paulo Bruno de Sousa},

title = {Avalia\c{c}\~{a}o da competi\c{c}\~{a}o no treino de agentes aut\^{o}nomos com Aprendizado Profundo por Refor\c{c}o em jogos de Tiro em Primeira Pessoa},

school = {Universidade Federal do Cear\'{a}},

year = {2018}

}